گرادیان کاهشی تصادفی

گرادیان کاهشی تصادفی الگو:به انگلیسی (اغلب به اختصار SGD خوانده میشود) روشی مبتنی بر تکرار برای بهینهسازی یک تابع مشتقپذیر به نام تابع هدف (تابع هزینه) است که یک تقریب تصادفی از روش گرادیان کاهشی میباشد. در حقیقت گرادیان کاهشی تصادفی الگوریتمی در اختیار ما قرار میدهد که طی چند حلقهٔ تکرار مقدار کمینه یک تابع و مقادیری را که با ازای آنها تابع کمینه مقدار خود را میگیرد، بدست بیاوریم. به تازگی مقالهای[۱] ابداع این روش را به هربرت رابینز و ساتِن مونرو (به انگلیسی: Herbert Robins and Sutton Monro) برای انتشار مقالهای در باب گرادیان کاهشی تصادفی در سال ۱۹۵۱ نسبت دادهاست. تفاوت گرادیان کاهشی تصادفی با گرادیان کاهشی استاندارد در این است که برخلاف گرادیان کاهشی استاندارد که برای بهینهسازی تابع هدف از تمام دادههای آموزشی استفاده میکند، گرادیان کاهشی تصادفی از گروهی از دادههای آموزشی که بهطور تصادفی انتخاب میشود برای بهینهسازی استفاده میکند. این روش در مسائل آماری و یادگیری ماشین کاربرد فراوانی دارد.

پیشینه

در برآوردهای آماری و یادگیری ماشین معمولاً مسائلی بهوجود میآید که در آنها نیاز است تابعی مانند از دادههای آماری با یک یا چند پارامتر (به شکل ضریب یا اشکال دیگر) تعریف کنیم و سپس این پارامترها را طوری مشخص کنیم که مجموع (یا میانگین) مقادیر تابع به ازای تک تک دادههای آماری، حداقل مقدار ممکن خود بشود. فرض کنید مجموعهای از دادههای آماری داریم و تابع را برای این دادهها فقط بر حسب یک پارامتر تعریف کردهایم، در این صورت با دادن داده ام از مجموعهٔ دادهها به تابع یک تابع از بدست میآوریم که آن را مینامیم. حال مسئله به پیدا کردن ای که عبارت زیر را کمینه میکند، ساده میشود: الگو:وسطچین الگو:پایان وسطچین یا به عبارت دیگر: الگو:وسطچین الگو:پایان وسطچین که همان تابع هدف یا تابع هزینه است.

برای حل چنین مسئلهای از گرادیان کاهشی استاندارد یا در مواردی از گرادیان کاهشی تصادفی استفاده میشود. در آمار کلاسیک زمینههایی مثل کمترین مربعات یا برآورد درستنمایی بیشینه، مسائلی مشابه در باب کمینهسازی مجموع جملات مطرح میشود. همچنین مسئلهٔ مینیممسازی جمع جملات در اصل کمینهسازی خطر تجربی (Empirical risk minimization) نیز مطرح میشود.

در بسیاری از موارد تابع هدف تابعی ساده میشود که اعمال روش گرادیان کاهشی روی آن پیچیده و زمانبر نیست در این موارد از روش گرادیان کاهشی استاندارد استفاده میشود، مانند خانوادهٔ توابع نمایی یک پارامتره که در ارزیابی توابع اقتصادی استفاده میشود. اما از آنجا که در روش گرادیان کاهشی استاندارد یا تصادفی به محاسبهٔ گرادیان تابع هدف در هر حلقه نیاز است، در بعضی از موارد که پارامترهای تابع هدف زیاد اند یا مجموعهٔ دادههای آموزشی بسیار بزرگ است محاسبهٔ انجام شده در هر حلقه میتواند بسیار زمانبر و پیچیده باشد به همین دلیل در این موارد از گرادیان کاهشی تصادفی استفاده میشود که در هر حلقه این عملیات را تنها برای بخشی از مجموعهٔ دادههای آموزشی که در اختیار داریم، انجام میدهد. در روش گرادیان کاهشی تصادفی در هر حلقه عملیات موردنظر بر روی تنها یک عضو مجموعهٔ دادههای آموزشی که در هر حلقه یهصورت تصادفی انتخاب میشود انجام نمیشود و در عوض بر روی زیرمجموعهای از آن انجام میشود؛ این امر دو دلیل دارد:[۲]

- پراکندگی مقدار بدست آمده برای پارامتر را در هر حلقه کم میکند و همگرایی پایدارتر پیش میرود.

- بهرهگیری از عملیات ماتریسی که پیادهسازی بسیار سریعی دارد.

کاربردها

گرادیان کاهشی تصادفی یک الگوریتم محبوب و متداول برای یادگیری طیف گستردهای از مدلها در یادگیری ماشین است، از جمله ماشینهای بردار پشتیبانی، رگرسیون لجستیک و مدلهای گرافیکی.[۳] الگوریتم بازگشت به عقب که عملاً الگوریتم استاندارد برای یادگیری شبکههای عصبی مصنوعی است در واقع روشی برای پیدا کردن گرادیان شبکه برای استفاده در گرادیان کاهشی تصادفی است.[۴] گرادیان کاهشی تصادفی در جامعه ژئوفیزیک نیز کاربردهایی دارد مانند مسئله وارونگی کامل شکلموج (FWI).[۵]

روش پیادهسازی

در پیادهسازی کلی گرادیان کاهشی تصادفی ابتدا بردار پارامترها که برداری است که شامل تمام پارامترهای تابع هزینه است را مینامیم. را برابر برداری دلخواه قرار میدهیم سپس برای هر بار بهروزرسانی این بردار یک عضو از مجموعهٔ دادههای آموزشی را به صورت تصادفی انتخاب کرده و با نرخ ، بردار حاصل از گرادیان تابع هزینه در نقطه را از کم میکنیم: الگو:وسطچین الگو:پایان وسطچین که در آن تابع هزینه و یک عضو از دادههای آموزشی است که به صورت تصادفی انتخاب شدهاست و نشاندهندهٔ جملهٔ ام از جملات تابع هدف است. نرخی است که با آن را بهروزرسانی میکنیم و مقداری تجربی دارد که اگر خیلی کوچک باشد زمان رسیدن به همگرایی را طولانی میکند و اگر خیلی بزرگ باشد ممکن است همگرایی رخ ندهد.[۶]

در پیادهسازی دیگر در هر حلقه عضوی تصادفی از مجموعهٔ دادهها انتخاب نمیشود بلکه در هر حلقه کل مجموعه دادهها یک بار بهصورت تصادفی بازچینی میشود سپس به عملیات بهروزرسانی به ترتیب به ازای انجام میشود که نشاندهندهٔ اندازهٔ مجموعهٔ دادههای آموزشی است. شبه کد زیر این پیادهسازی را نشان میدهد:

به و مقدار اولیه بده

تا زمانی که کمینه بدست بیاید تکرار کن

دادههای آموزشی را به صورت تصادفی بازچینی کن

برای از ۱ تا n تکرار کن:

همانطور که پیشتر اشاره شد معمولاً عملیات بهروز رسانی برای

حاصل از یک تک عضو مجموعهٔ دادههای آموزشی انجام نمیشود و برای زیرمجموعهای از این دادهها انجام میشود که به آن دستهٔ کوچک میگویند.

-

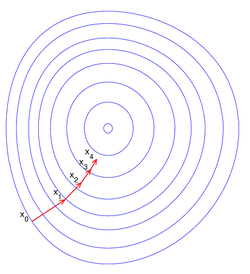

نحوهٔ عملکرد گرادیان کاهشی برای تابع یک ورودی

-

نحوهٔ عملکرد گرادیان کاهشی برای تابع دو ورودی

مثال

فرض کنید در یک مسئلهٔ یادگیری ماشین میخواهیم از روش کمترین مربعات استفاده کنیم به طوری که مجموعهای از دادههای آموزشی به شکل داریم که در هر دوتایی، نشاندهندهٔ مساحت یک خانه و نشاندهندهٔ قیمت خانه به آن مساحت باشد حال اگر بخواهیم نمودار را بر حسب با یک نمدار خطی تقریب بزنیم نیاز به روش کمترین مربعات داریم. طبق این روش بهترین تقریب این نمودار با خط زمانی اتفاق میافتد که تابع کمینه مقدار خود را داشته باشد. حال در این مثال تابع هزینه است و به روش گرادیان کاهشی تصادفی میشود مقدار را بدست آورد که با ازای آنها تابع هزینه کمینه شود و بهترین تقریب خطی یرای نمودار بدست بیاید.[۷]

بسط

تا به حال چندین روش نوین برای کاهش سریعتر گرادیان کاهشی ابداع شده که ذیلاً بعضی مورد بررسی قرار گرفتهاند.[۸][۹][۱۰][۱۱][۱۲]

تکانه (Momentum)

این روش برای اولین بار توسط روملهارت، هیلتون و ویلیامز معرفی شد.[۸] در این روش میزان تغییر پارامتر در هر مرحله از بهینهسازی ذخیره شده تا در مرحله بعدی به شکل پایین از آن استفاده شود: الگو:وسطچین

الگو:پایان وسطچین که با ترکیب این دو به عبارت پایین میرسیم: الگو:وسطچین الگو:پایان وسطچین روش momentum باعث میشود که مسیر پارامتر خیلی تغییر نکند و نوسانات شدیدی نداشته باشد. استفاده از این روش در شبکههای عصبی مصنوعی متداول است و معمولاً موجب بهبود دقت شبکههای عصبی میشود.[۱۳]

میانگین (Averaging)

در این روش در هر مرحله پارامترهای مرحله پیشین ذخیره میشود و در نهایت میانگین آنها به عنوان پارامتر بهینه برگردانده میشود[۹] یعنی .

گرادیان تطبیقی (AdaGrad)

روش آداگراد یا گرادیان تطبیقی برای اولین بار در سال ۲۰۱۱ معرفی و منتشر شد.[۱۰][۱۴] این روش برای هر بُعدِ پارامتر یک نرخ یادگیری جداگانهای در نظر میگیرد؛ نرخ یادگیری همان در معادله بالاست. برای ابعاد خلوتتر (sparse) معمولاً این روش نرخ یادگیری را افزایش میدهد و برای ابعادی که مقادیر صفر کمتری دارند نرخ یادگیری را کاهش میدهد. این روش اغلب برای مسائلی که با دادههای خلوت سروکار دارند مانند پردازش تصویر یا زبانهای طبیعی بهینهتر است و همگرایی را تسریع میبخشد.[۱۰]

نرخ یادگیری برای ابعاد مختلف پارامتر از قطر اصلی ضرب خارجی بدست میآید. در این معادله گرادیان در مرحله است و نرخ یادگیری برای بُعدِ برابر خواهد بود با: الگو:وسطچین الگو:پایان وسطچین حال میتوان پارامتر را به صورت پایین بهروز کرد: الگو:وسطچین الگو:پایان وسطچین این معادله برای بعد برابر خواهد بود با: الگو:وسطچین الگو:پایان وسطچین از آنجا که در نرخ یادگیری برای بُعدِ j ام پارامتر بر مقدار تقسیم میشود، ابعدای که خلوتترند سریعتر نرخ یادگیریشان کاهش مییابد.[۱۵] اگرچه روش گرادیان تطبیقی برای مسائل محدب طراحی شدهاست ولی برای مسائل غیر محدب نیز نتایج خوبی به بار آوردهاست.[۱۶]

RMSProp

در این روش همانند گرادیان تطبیقی برای هر بُعدِ پارامتر نرخ یادگیری جداگانهای در نظر گرفته میشود.[۱۱] ایده اصلی این است که نرخ یادگیری را برای یک بُعد بر میانگین گرادیانهای آن بُعد تقسیم کنیم؛ بنابراین، ابتدا میانگین را به این شکل محاسبه میکنیم: الگو:وسطچین الگو:پایان وسطچین در این معادله ضریب فراموشی است و پارامترها به این صورت بروز میشوند: الگو:وسطچین الگو:پایان وسطچین این روش نتایج بسیار خوبی برای مسائل مختلف بهینهسازی دادهاست.[۱۷]

Adam

این روش مشابه روش RMSProp است با این تفاوت که هم از میانگین گرادیان و هم از گشتاورهای دوم آن به شکل پایین استفاده میشود.[۱۲] الگو:وسطچین

الگو:پایان وسطچین در اینجا برای جلوگیری از صفر شدن مخرج است، و ضرایب فراموشی گرادیان و گشتاور دوم گرادیان هستند. مربع گرادیانها مولفهای است. کاربرد ضرایب فراموشی گرادیان و گشتاور دوم گرادیان بیشتر برای جبران فاصله مقدار تقریبی از مقدار واقعی گرادیان می باشد،که معمولا برای زمانی که t کوچک است مفید می باشد. روش Adam رایج ترین روش در شبکه های عصبی عمیق برای تعلیم شبکه می باشد

جستارهای وابسته

منابع

- ↑ الگو:Cite journal

- ↑ الگو:یادکرد وب

- ↑ Jenny Rose Finkel, Alex Kleeman, Christopher D. Manning (2008). Efficient, Feature-based, Conditional Random Field Parsing الگو:Webarchive. Proc. Annual Meeting of the ACL.

- ↑ الگو:یادکرد وب

- ↑ Díaz, Esteban and Guitton, Antoine. "Fast full waveform inversion with random shot decimation". SEG Technical Program Expanded Abstracts, 2011. 2804-2808الگو:پیوند مرده

- ↑ الگو:یادکرد وب

- ↑ الگو:یادکرد وب

- ↑ ۸٫۰ ۸٫۱ الگو:Cite journal

- ↑ ۹٫۰ ۹٫۱ الگو:Cite journal

- ↑ ۱۰٫۰ ۱۰٫۱ ۱۰٫۲ الگو:Cite journal

- ↑ ۱۱٫۰ ۱۱٫۱ Tieleman, Tijmen and Hinton, Geoffrey (2012). Lecture 6.5-rmsprop: Divide the gradient by a running average of its recent magnitude. COURSERA: Neural Networks for Machine Learning

- ↑ ۱۲٫۰ ۱۲٫۱ الگو:Cite arXiv

- ↑ الگو:Cite arXiv

- ↑ الگو:Cite web

- ↑ الگو:Cite arXiv

- ↑ الگو:Cite journal

- ↑ الگو:Cite web